本文最后更新于 771 天前,其中的信息可能已经有所发展或是发生改变。

部署属于你自己的 Novel AI 作画服务!

前言

最近 AI 作画大火,有正巧碰上 Novel AI 的 Stable Diffusion 模型泄露,因此大家都在摩肩擦掌试图搭一个自己的 AI 作画服务。我也差不多试了一些方式,最后总结了几种不错(关键是无脑,简单)的在本地部署 AI 作画服务的方式,供大家参考。

(这里默认大家都是 Windows 操作系统,如果您是 Linux 操作系统,请您遵照原文(对于 NAIFU,请遵照项目内的 README.MD 文件)部署。

stable-diffusion-webui

参考 --VOLDY RETARD GUIDE-- (rentry.org) 网站的说明,部署一个使用 stable-diffusion-webui 作为前端的 AI 作画服务:

这需要:

- 不低于 16 GB 的运行内存

- Nvidia Maxwell 架构或更新版本的 GPU,带有 至少 2 GB 显存

- Linux 或 Windows 7/8/10+

- 不少于 20 GB 的磁盘空间

安装方式:

- 安装 Git;

- 找一个有磁盘空间的地方,右键,选择

Git Bash here,然后键入git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui,等待拉取仓库完成; - 下载 Stable Diffusion 1.4 AI 模型 huggingface(需要注册)或者通过 这里-(磁力链);

- 或者,你可以下载基于上述模型的 Waifu(二次元老婆)模型,通过 这里 (镜像)-(磁力链);

- 把你得到的模型文件改名为

model.ckpt,将他放到上面拉取好的仓库文件夹的/models/Stable-diffusion文件夹内; - 安装 Python 3.10.6 (Windows 7 版本) (原站),确保你再安装的时候选择了 Add Python to PATH 选项;

- 以 非管理员身份 运行

webui-user.bat; - 访问

http://localhost:7860查看部署好的 stable-diffusion-webui 服务。 - 额外的,如果你想使用 Novel AI 的原装模型,你需要这么做:

- 下载泄露的模型:

magnet:?xt=urn:btih:5bde442da86265b670a3e5ea3163afad2c6f8ecc&dn=novelaileak&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce&tr=udp%3A%2F%2F9.rarbg.com%3A2810%2Fannounce&tr=udp%3A%2F%2Ftracker.openbittorrent.com%3A6969%2Fannounce&tr=http%3A%2F%2Ftracker.openbittorrent.com%3A80%2Fannounce&tr=udp%3A%2F%2Fopentracker.i2p.rocks%3A6969%2Fannounce; - 将其中一个模型文件(model.ckpt,这里推荐

animefull-latest)从stableckpt文件夹移动到webui/models/Stable-diffusion; - (可选,可能导致效果更好或更差)将

stableckpt/animevae.pt移动到webui/models/Stable-diffusion,改名为model.vae.pt; - 将

stableckpt/modules/modules/文件夹内的所有文件(它们应当都是.pt结尾的)移动到webui/models/hypernetworks文件夹,如果后者不存在,则请创建一个; - 重新运行

webui-user.bat即可。 - 根据相关情报,Novel AI 的模型最好适用于下述配置:

- CFG scale: 11

- negative prompt: lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry

- prompt 前缀: masterpiece, best quality

- 下载泄露的模型:

部署效果:

Novel AI 原版前后端

如果你体验过 Novel AI,那么你应该知道他的原版前端是十分舒服的,如果想运行 Novel AI 的同款前后端,现在有一个名为 NAIFU 的项目可以帮你实现这一点。

注意,NAIFU 对计算机的性能要求可能比上面的更高,因此请谨慎抉择。

NAIFU 需要在 Windows 或 Linux 操作系统,并拥有至少 8 GB 显存来运行。

安装方式:

- 下载 NAIFU:

magnet:?xt=urn:btih:4a4b483d4a5840b6e1fee6b0ca1582c979434e4d&dn=naifu&tr=udp%3a%2f%2ftracker.opentrackr.org%3a1337%2fannounce - 安装 Python,别忘了选择

Add Python to PATH - 将

NAIFU项目目录的program.zip压缩包解压到该目录(注意不是解压到program目录) - 运行

setup.bat,等待安装完成。 - 运行

run.bat,启动程序。 - 访问

http://localhost:6969查看部署好的 Novel AI 服务。

部署效果:

Enjoy it!

我的博客即将同步至腾讯云开发者社区,邀请大家一同入驻:https://cloud.tencent.com/developer/support-plan?invite_code=2gf79vq5jicks

核显用户骂骂咧咧的退出群聊,想收的显卡全是矿。

可以尝试非本地白嫖部署,Google Colab等,参考:github.com/JingShing/novelai-colab-ver或colab.research.google.com/drive/1_Ma71L6uGbtt6UQyA3FjqW2lcZ5Bjck

当然也有其它各种魔改衍生也非常多…

无妨,已经下单了一块 57xt,准备享受色图了;-P

![]()

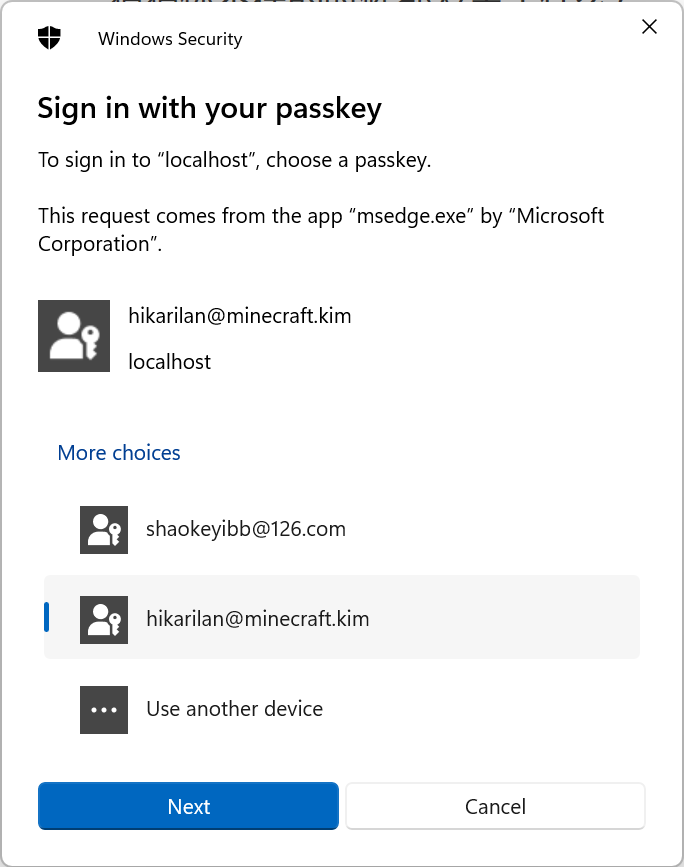

感谢贺兰,很好用。

查看图片

来交作业了.http://yostar.moe:25566/

nice waifu , nice job.

好哎ヾ(≧∇≦*)ゝ

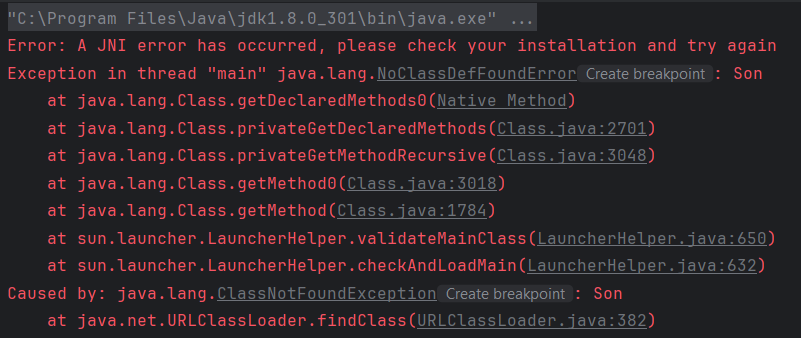

这边给可能出的问题留个解决方案 😀

A卡跑提示 RuntimeError: “LayerNormKernelImpl” not implemented for ‘Half’ 的话

在 webui-user.bat 中修改为

set COMMANDLINE_ARGS= --precision full --no-half如果已经加了--skip-torch-cuda-test就在他后面追加我的还是不行诶,我用的是整合包,显卡是2G的集成显卡,跑的是 显存4G.bat,请问还有解决方法吗?

补充一下以防误导…A卡直接是不行的,后来才发现压根没用显卡,实际是它在cpu上硬跑…..